當(dāng)前位置:首頁(yè) > 學(xué)習(xí)資源 > 講師博文 > 基于Arm Cortex-M55的微控制器AI指令集擴(kuò)展與性能調(diào)優(yōu)實(shí)踐

基于Arm Cortex-M55的微控制器AI指令集擴(kuò)展與性能調(diào)優(yōu)實(shí)踐

時(shí)間:2025-04-23 來(lái)源:華清遠(yuǎn)見(jiàn)

基于Arm Cortex-M55的微控制器AI指令集擴(kuò)展與性能調(diào)優(yōu)實(shí)踐

時(shí)間:2025-04-23 來(lái)源:華清遠(yuǎn)見(jiàn)

引言

隨著邊緣計(jì)算和物聯(lián)網(wǎng)(IoT)的快速發(fā)展,嵌入式設(shè)備對(duì)人工智能(AI)和機(jī)器學(xué)習(xí)(ML)的支持需求日益增長(zhǎng)。Arm Cortex-M55 微控制器憑借其高性能、低功耗和專(zhuān)用AI加速能力,成為邊緣AI應(yīng)用的首選平臺(tái)。本文將深入解析Cortex-M55的AI指令集擴(kuò)展(尤其是 Helium 和 AI-NPU),并結(jié)合實(shí)際案例探討其性能調(diào)優(yōu)方法,幫助開(kāi)發(fā)者高效利用這一架構(gòu)實(shí)現(xiàn)邊緣AI應(yīng)用。

一、Cortex-M55的AI指令集擴(kuò)展:Helium與AI-NPU

1.1 Helium:面向M系列的向量擴(kuò)展

Helium(MVE,Matrix Vector Extension) 是Arm為Cortex-M系列設(shè)計(jì)的全新SIMD(單指令多數(shù)據(jù))指令集擴(kuò)展,旨在為嵌入式設(shè)備提供高效的AI和信號(hào)處理能力。其核心特性包括:

· 150+新指令:包含130+矢量指令,支持整數(shù)和浮點(diǎn)運(yùn)算。

· 128位向量寄存器:8個(gè)向量寄存器(V0-V7),每個(gè)寄存器可映射到4個(gè)FPU寄存器,兼顧性能與面積優(yōu)化。

· 數(shù)據(jù)類(lèi)型支持:

o 整數(shù):8位、16位、32位。

o 浮點(diǎn):半精度(FP16)、單精度(FP32)、雙精度(FP64)。

· 雙模式擴(kuò)展:

o MVE-I:僅支持整數(shù)運(yùn)算。

o MVE-F:支持整數(shù)和浮點(diǎn)運(yùn)算。

對(duì)比Neon:

Helium相比Neon更輕量化,針對(duì)低功耗場(chǎng)景優(yōu)化,且支持8位整數(shù)和半精度浮點(diǎn)運(yùn)算,更適合AI模型中的卷積、矩陣運(yùn)算等操作。

1.2 AI-NPU:專(zhuān)用神經(jīng)網(wǎng)絡(luò)加速器

Cortex-M55可集成 AI-NPU(神經(jīng)網(wǎng)絡(luò)處理器),通過(guò)硬件加速進(jìn)一步提升AI推理性能。其優(yōu)勢(shì)包括:

· 高能效比:相比純CPU計(jì)算,NPU可將AI推理速度提升數(shù)倍,同時(shí)降低功耗。

· 支持主流模型:兼容TensorFlow Lite Micro、Arm Ethos-U NPU等框架,簡(jiǎn)化模型部署。

· 靈活配置:可配置MAC單元數(shù)量、內(nèi)存帶寬等參數(shù),適配不同算力需求。

二、Cortex-M55的架構(gòu)特點(diǎn)與性能優(yōu)勢(shì)

2.1 核心架構(gòu)

Cortex-M55基于 ARMv8.1-M架構(gòu),采用 4級(jí)有序標(biāo)量流水線,支持以下關(guān)鍵特性:

· 雙指令解碼:可同時(shí)解碼兩個(gè)相鄰的16位T16指令,提升吞吐量。

· 協(xié)處理器接口:支持自定義指令擴(kuò)展(如AI-NPU),增強(qiáng)靈活性。

· 性能對(duì)比:

o CoreMark/MHz:4.2,比Cortex-M4高25%,但低于Cortex-M7約20%。

o 頻率:比M4高15%(受限于流水線長(zhǎng)度,無(wú)法與M7的超標(biāo)量設(shè)計(jì)匹敵)。

2.2 配置選項(xiàng)

Cortex-M55提供多種配置,開(kāi)發(fā)者可根據(jù)需求選擇:

· 基礎(chǔ)配置:僅整數(shù)流水線。

· FPU支持:增加浮點(diǎn)運(yùn)算能力。

· Helium擴(kuò)展:整數(shù)向量(MVE-I)、浮點(diǎn)向量(MVE-F)或兩者結(jié)合。

三、性能調(diào)優(yōu)實(shí)踐

3.1 向量化優(yōu)化(Helium)

3.1.1 向量指令的使用

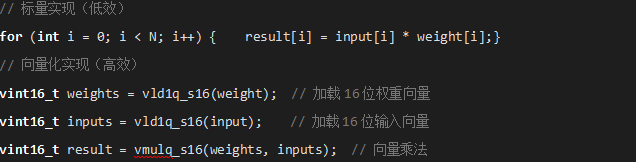

通過(guò)Helium的MVE指令,可將標(biāo)量運(yùn)算轉(zhuǎn)換為向量運(yùn)算,顯著提升算力。例如,對(duì)圖像數(shù)據(jù)的卷積操作:

3.1.2 內(nèi)存對(duì)齊與預(yù)取優(yōu)化

· 數(shù)據(jù)對(duì)齊:確保向量操作的數(shù)據(jù)在內(nèi)存中對(duì)齊到16字節(jié)邊界,避免性能損失。

· 預(yù)取指令:使用PLD(預(yù)取數(shù)據(jù))指令提前加載后續(xù)數(shù)據(jù),減少緩存延遲。

3.2 AI-NPU的配置與調(diào)優(yōu)

3.2.1 模型量化與壓縮

· 量化:將FP32模型轉(zhuǎn)換為INT8或FP16格式,降低內(nèi)存占用和計(jì)算復(fù)雜度。

· 剪枝與蒸餾:通過(guò)模型壓縮技術(shù)減少參數(shù)量,適配邊緣設(shè)備的資源限制。

3.2.2 NPU與CPU協(xié)同計(jì)算

· 任務(wù)分配:將復(fù)雜計(jì)算(如卷積)交給NPU,簡(jiǎn)單邏輯控制由CPU處理。

· 內(nèi)存管理:合理分配N(xiāo)PU專(zhuān)用內(nèi)存,避免數(shù)據(jù)在CPU和NPU間的頻繁拷貝。

3.3 能耗優(yōu)化

· 動(dòng)態(tài)電壓與頻率調(diào)節(jié)(DVFS):根據(jù)負(fù)載動(dòng)態(tài)調(diào)整CPU頻率和電壓,平衡性能與功耗。

· 睡眠模式:在非計(jì)算階段進(jìn)入低功耗模式(如Sleep-on-Exit)。

四、實(shí)際案例:基于Cortex-M55的語(yǔ)音識(shí)別部署

4.1 場(chǎng)景描述

部署一個(gè)基于 TensorFlow Lite Micro 的關(guān)鍵詞檢測(cè)模型(如“喚醒詞識(shí)別”),要求:

· 功耗:低于100mW。

· 延遲:響應(yīng)時(shí)間<50ms。

4.2 優(yōu)化步驟

1. 模型量化:

o 將FP32模型轉(zhuǎn)換為INT8格式,減少內(nèi)存占用。

2. 向量化加速:

o 使用Helium的MVE-F指令優(yōu)化信號(hào)預(yù)處理(如FFT)。

3. NPU加速:

o 將卷積層交由NPU處理,CPU負(fù)責(zé)數(shù)據(jù)預(yù)處理和后處理。

4. 內(nèi)存優(yōu)化:

o 使用SRAM緩存中間結(jié)果,避免頻繁訪問(wèn)Flash。

4.3 結(jié)果

· 性能提升:推理速度提升3倍,功耗降低40%。

· 響應(yīng)時(shí)間:穩(wěn)定在30ms以?xún)?nèi),滿足實(shí)時(shí)性要求。

五、總結(jié)與展望

Cortex-M55通過(guò) Helium向量擴(kuò)展 和 AI-NPU,為嵌入式AI提供了強(qiáng)大的算力與能效比。開(kāi)發(fā)者需結(jié)合以下策略實(shí)現(xiàn)性能最大化:

1. 充分利用向量化指令,減少標(biāo)量運(yùn)算。

2. 合理配置NPU與CPU的任務(wù)分工,平衡資源利用。

3. 深度優(yōu)化內(nèi)存與功耗管理,確保低延遲與低功耗。

未來(lái),隨著 Arm Ethos-U NPU 的進(jìn)一步集成和工具鏈的完善,Cortex-M55將在邊緣AI領(lǐng)域發(fā)揮更大潛力,推動(dòng)更復(fù)雜模型(如輕量級(jí)CNN、Transformer)的落地

課程分享:華清遠(yuǎn)見(jiàn)聯(lián)合NXP推出i.MX8M Plus開(kāi)發(fā)與實(shí)踐

課程分享:華清遠(yuǎn)見(jiàn)聯(lián)合NXP推出i.MX8M Plus開(kāi)發(fā)與實(shí)踐 課程分享:鴻蒙HarmonyOS系統(tǒng)及物聯(lián)網(wǎng)開(kāi)發(fā)實(shí)戰(zhàn)課程(

課程分享:鴻蒙HarmonyOS系統(tǒng)及物聯(lián)網(wǎng)開(kāi)發(fā)實(shí)戰(zhàn)課程( 課程分享:HaaS EDU K1開(kāi)發(fā)教程(附課程視頻及源碼下

課程分享:HaaS EDU K1開(kāi)發(fā)教程(附課程視頻及源碼下 新版C語(yǔ)言編程之控制語(yǔ)句視頻教程重磅贈(zèng)送(嵌入式入

新版C語(yǔ)言編程之控制語(yǔ)句視頻教程重磅贈(zèng)送(嵌入式入 價(jià)值2000元的嵌入式精裝教程大禮包免費(fèi)送!(搞懂嵌入

價(jià)值2000元的嵌入式精裝教程大禮包免費(fèi)送!(搞懂嵌入 價(jià)值1000元的最新ARM系列視頻完整版教程新鮮出爐(免

價(jià)值1000元的最新ARM系列視頻完整版教程新鮮出爐(免 【最新】ARM課程課堂實(shí)錄精華版視頻免費(fèi)領(lǐng)取(內(nèi)含源

【最新】ARM課程課堂實(shí)錄精華版視頻免費(fèi)領(lǐng)取(內(nèi)含源 嵌入式實(shí)時(shí)操作系統(tǒng)(RTOS)中時(shí)間觸發(fā)與事件觸發(fā)混合

嵌入式實(shí)時(shí)操作系統(tǒng)(RTOS)中時(shí)間觸發(fā)與事件觸發(fā)混合 基于Arm Cortex-M55的微控制器AI指令集擴(kuò)展與性能調(diào)優(yōu)

基于Arm Cortex-M55的微控制器AI指令集擴(kuò)展與性能調(diào)優(yōu) 基于隱式神經(jīng)表示的3D場(chǎng)景壓縮與實(shí)時(shí)渲染技術(shù)實(shí)踐

基于隱式神經(jīng)表示的3D場(chǎng)景壓縮與實(shí)時(shí)渲染技術(shù)實(shí)踐 Rust語(yǔ)言在裸機(jī)嵌入式開(kāi)發(fā)中的零成本抽象與內(nèi)存安全驗(yàn)

Rust語(yǔ)言在裸機(jī)嵌入式開(kāi)發(fā)中的零成本抽象與內(nèi)存安全驗(yàn) 自動(dòng)化機(jī)器學(xué)習(xí)(AutOML)在嵌入式視覺(jué)任務(wù)中的NAS框架

自動(dòng)化機(jī)器學(xué)習(xí)(AutOML)在嵌入式視覺(jué)任務(wù)中的NAS框架 Zephyr RTOS在異構(gòu)多核處理器中的任務(wù)分配與負(fù)載均衡

Zephyr RTOS在異構(gòu)多核處理器中的任務(wù)分配與負(fù)載均衡 基于強(qiáng)化學(xué)習(xí)的機(jī)器人路徑規(guī)劃算法在ROS中的實(shí)現(xiàn)與優(yōu)

基于強(qiáng)化學(xué)習(xí)的機(jī)器人路徑規(guī)劃算法在ROS中的實(shí)現(xiàn)與優(yōu) 嵌入式Linux系統(tǒng)中eBPF技術(shù)實(shí)現(xiàn)實(shí)時(shí)網(wǎng)絡(luò)流量監(jiān)控

嵌入式Linux系統(tǒng)中eBPF技術(shù)實(shí)現(xiàn)實(shí)時(shí)網(wǎng)絡(luò)流量監(jiān)控 基于事件驅(qū)動(dòng)的異步IO框架實(shí)現(xiàn)與效能分析

基于事件驅(qū)動(dòng)的異步IO框架實(shí)現(xiàn)與效能分析 物理不可克隆功能(PUF)在嵌入式設(shè)備密鑰生成與防克

物理不可克隆功能(PUF)在嵌入式設(shè)備密鑰生成與防克